World wide web adalah sumber yang mencakup semua dan utama dari semua data yang ada. Perkembangan pesat yang telah dilihat internet dalam tiga dekade terakhir belum pernah terjadi sebelumnya. Akibatnya, web dipasang dengan ratusan terabyte data setiap hari every.

Semua data ini memiliki beberapa nilai untuk seseorang tertentu. Misalnya, riwayat penjelajahan Anda memiliki arti penting untuk aplikasi media sosial, karena mereka menggunakannya untuk mempersonalisasi iklan yang mereka tunjukkan kepada Anda. Dan ada banyak persaingan untuk data ini juga; beberapa MB lebih banyak dari beberapa data dapat memberi bisnis keunggulan substansial dalam persaingan mereka.

Penambangan data dengan Python

Untuk membantu Anda yang baru dalam pengikisan data, kami telah menyiapkan panduan ini di mana kami akan menunjukkan cara mengikis data dari web menggunakan Python dan Pustaka sup Indah.

Kami berasumsi bahwa Anda sudah memiliki keakraban menengah dengan Python dan HTML, karena Anda akan bekerja dengan keduanya mengikuti petunjuk dalam panduan ini.

Berhati-hatilah dengan situs mana Anda mencoba keterampilan penambangan data yang baru Anda temukan, karena banyak situs menganggap ini mengganggu dan tahu bahwa mungkin ada akibatnya.

Memasang dan menyiapkan Perpustakaan

Sekarang, kita akan menggunakan dua perpustakaan yang akan kita gunakan: perpustakaan permintaan python untuk memuat konten dari halaman web dan perpustakaan Beautiful Soup untuk bit proses yang sebenarnya. Ada alternatif untuk BeautifulSoup, ingatlah, dan jika Anda terbiasa dengan salah satu dari yang berikut ini, silakan gunakan ini sebagai gantinya: Scrappy, Mechanize, Selenium, Portia, kimono, dan ParseHub.

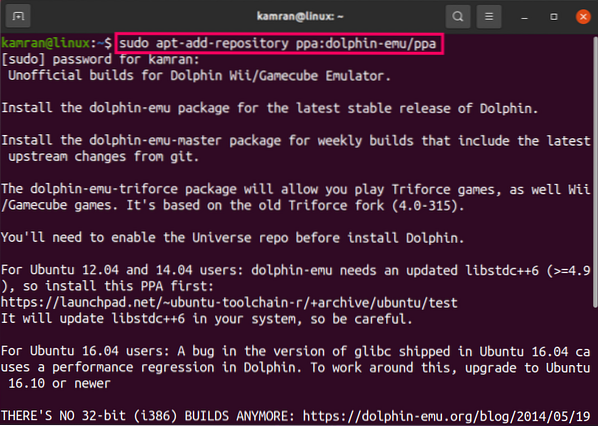

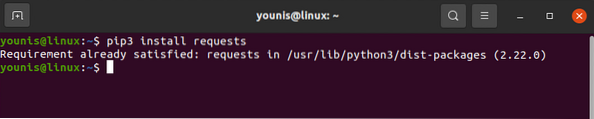

Pustaka permintaan dapat diunduh dan diinstal dengan perintah pip seperti di bawah:

# permintaan pemasangan pip3

Pustaka permintaan harus dipasang di perangkat Anda. Demikian pula, unduh BeautifulSoup juga:

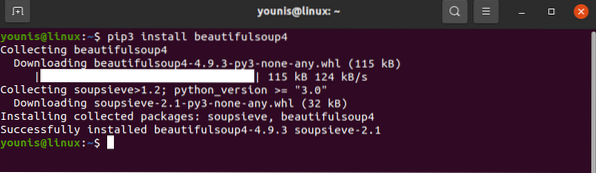

# pip3 instal beautifulsoup4

Dengan itu, perpustakaan kami siap untuk beberapa tindakan.

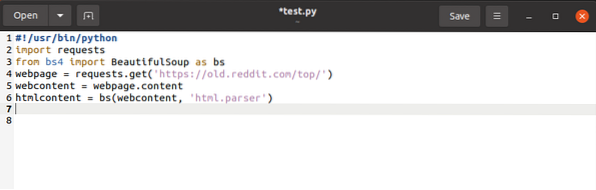

Seperti disebutkan di atas, perpustakaan permintaan tidak memiliki banyak kegunaan selain mengambil konten dari halaman web. Pustaka BeautifulSoup dan pustaka permintaan memiliki tempat di setiap skrip yang akan Anda tulis, dan mereka harus diimpor sebelum masing-masing sebagai berikut:

$permintaan impor$dari bs4 impor BeautifulSoup sebagai bs

Ini menambahkan kata kunci yang diminta ke namespace, memberi sinyal ke Python arti kata kunci setiap kali penggunaannya diminta. Hal yang sama terjadi pada kata kunci bs, meskipun di sini kita mendapat manfaat dengan menetapkan kata kunci yang lebih sederhana untuk BeautifulSoup.

halaman web = permintaan.dapatkan (URL)Kode di atas mengambil URL halaman web dan membuat string langsung darinya, menyimpannya ke dalam variabel.

$konten web = halaman web.kandunganPerintah di atas menyalin konten halaman web dan menetapkannya ke konten web variabel.

Dengan itu, kita selesai dengan perpustakaan permintaan request. Yang tersisa untuk dilakukan adalah mengubah opsi perpustakaan permintaan menjadi opsi BeautifulSoup.

$htmlkonten = bs(konten web, “html.pengurai“)

Ini mem-parsing objek permintaan dan mengubahnya menjadi objek HTML yang dapat dibaca.

Dengan itu semua diurus, kita bisa beralih ke bit pengikisan yang sebenarnya.

Pengikisan web dengan Python dan BeautifulSoup

Mari kita lanjutkan dan lihat bagaimana kita dapat mengikis objek HTML data dengan BeautifulSoup.

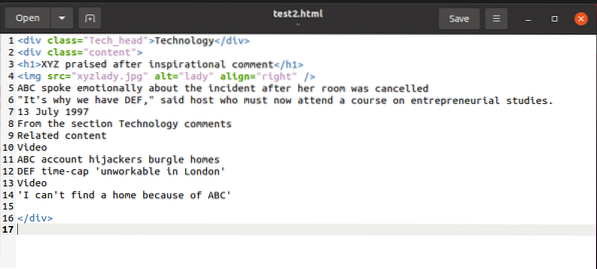

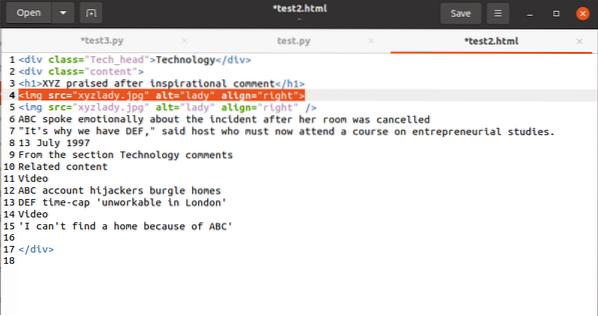

Untuk mengilustrasikan sebuah contoh, sementara kami menjelaskan berbagai hal, kami akan bekerja dengan cuplikan html ini:

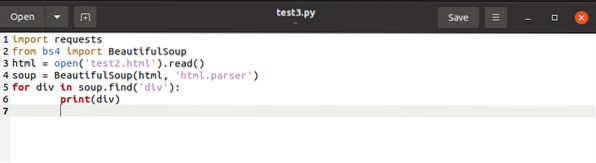

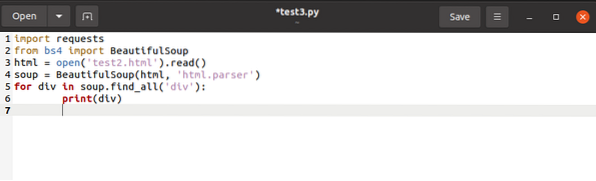

Kami dapat mengakses konten cuplikan ini dengan BeautifulSoup dan menggunakannya pada variabel konten HTML seperti di bawah:

Kode di atas mencari setiap tag bernama

Untuk secara bersamaan menyimpan tag bernama

ke daftar, kami akan mengeluarkan kode akhir seperti di bawah:

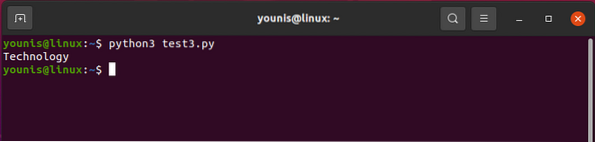

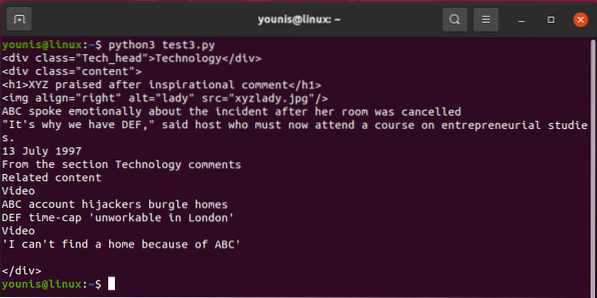

Outputnya harus kembali seperti ini:

Untuk memanggil salah satu dari

Sekarang mari kita lihat cara memilih

tag tetap dalam perspektif karakteristik mereka. Untuk memisahkan , kita membutuhkan

untuk div dalam sup.find_all('div',attrs='class'='Tech_head'):

Ini mengambil

menandai.Anda akan mendapatkan:

Teknologi

Semua tanpa tag.

Terakhir, kita akan membahas cara memilih nilai atribut dalam sebuah tag. Kode harus memiliki tag ini:

Untuk mengoperasikan nilai yang terkait dengan atribut src, Anda akan menggunakan yang berikut ini:

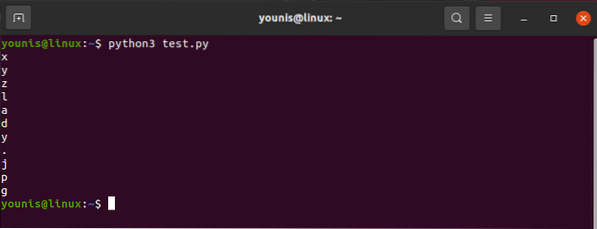

htmlkonten.temukan(“img“)[“src“]Dan outputnya akan berubah menjadi:

"images_4/a-beginners-guide-to-web-scraping-with-python-and-beautiful-sup.jpg"

Ya ampun, itu pasti banyak pekerjaan!

Jika Anda merasa keakraban Anda dengan python atau HTML tidak memadai atau jika Anda hanya kewalahan dengan web scraping, jangan khawatir.

Jika Anda adalah bisnis yang perlu memperoleh jenis data tertentu secara teratur tetapi tidak dapat melakukan pengikisan web sendiri, ada beberapa cara untuk mengatasi masalah ini. Tapi ketahuilah bahwa itu akan menghabiskan sejumlah uang. Anda dapat menemukan seseorang untuk melakukan pengikisan untuk Anda, atau Anda bisa mendapatkan layanan data premium dari situs web seperti Google dan Twitter untuk berbagi data dengan Anda. Ini berbagi sebagian data mereka dengan menggunakan API, tetapi panggilan API ini dibatasi per hari. Selain itu, situs web seperti ini bisa sangat melindungi data mereka. Biasanya banyak situs semacam itu tidak membagikan data mereka sama sekali.

Pikiran terakhir

Sebelum kita mengakhiri, izinkan saya memberi tahu Anda dengan lantang jika itu belum terbukti dengan sendirinya; perintah find(), find_all() adalah teman terbaik Anda saat Anda keluar dengan BeautifulSoup. Meskipun masih banyak lagi yang harus dibahas untuk menguasai pengikisan data dengan Python, panduan ini sudah cukup bagi Anda yang baru memulai.

Phenquestions

Phenquestions